Manipuler les images pour désinformer

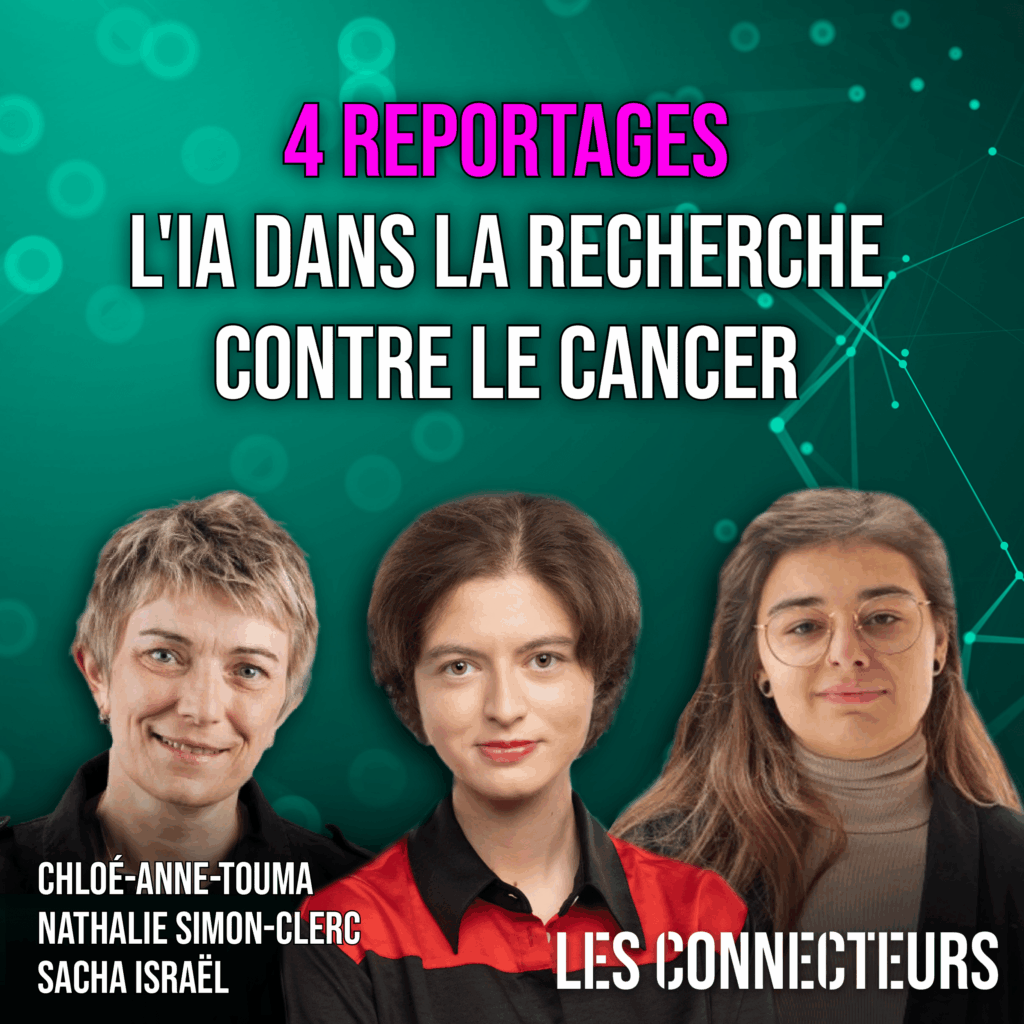

Par Nathalie Simon-Clerc, journaliste pour LES CONNECTEURS | Publié le 9 avril 2025

Lire l’article tel que paru dans la revue animée et interactive LES CONNECTEURS, ou poursuivre la lecture sur cette page plus bas

Apparue il y a environ trois ans, la désinformation visuelle inonde nos téléphones intelligents. Insidieuse, plus sournoise que la désinformation textuelle, elle percole dans nos réseaux sociaux et se propage au bout du monde à vitesse grand V, jusqu’à duper le plus attentif des internautes.

L’image est une aubaine pour les propagateurs de fausses informations. Elle se vole, se triture, se rogne, change de message, parle toutes les langues, se partage rapidement et voyage vite au bout du monde.

Au cours d’une table ronde organisée le 27 mars 2025, sur le thème de « La désinformation visuelle et modale » au Centre de Recherche Informatique de Montréal (CRIM), Marc Lalonde, spécialiste en vision par ordinateur Recherche au CRIM, et Benoit Yelle, associé et agent de brevets au Canada et aux États-Unis chez Lavery, ont décrypté les ressorts de la désinformation visuelle.

Manipuler les images

La recontextualisation d’image est la manière la plus simple. « Vous avez un message que vous voulez relayer ou diffuser, potentiellement trompeur? Vous cherchez une image qui renforce votre message, vous la sortez de son contexte pour l’insérer dans votre propre contexte, justifiant le discours qui vous arrange », explique Marc Lalonde. Il donne l’exemple de la photo de Barack Obama et Nancy Pelosi visitant un laboratoire, qui, dans un contexte de propagateurs de fausses nouvelles, mettent en place la pandémie de Covid-19.

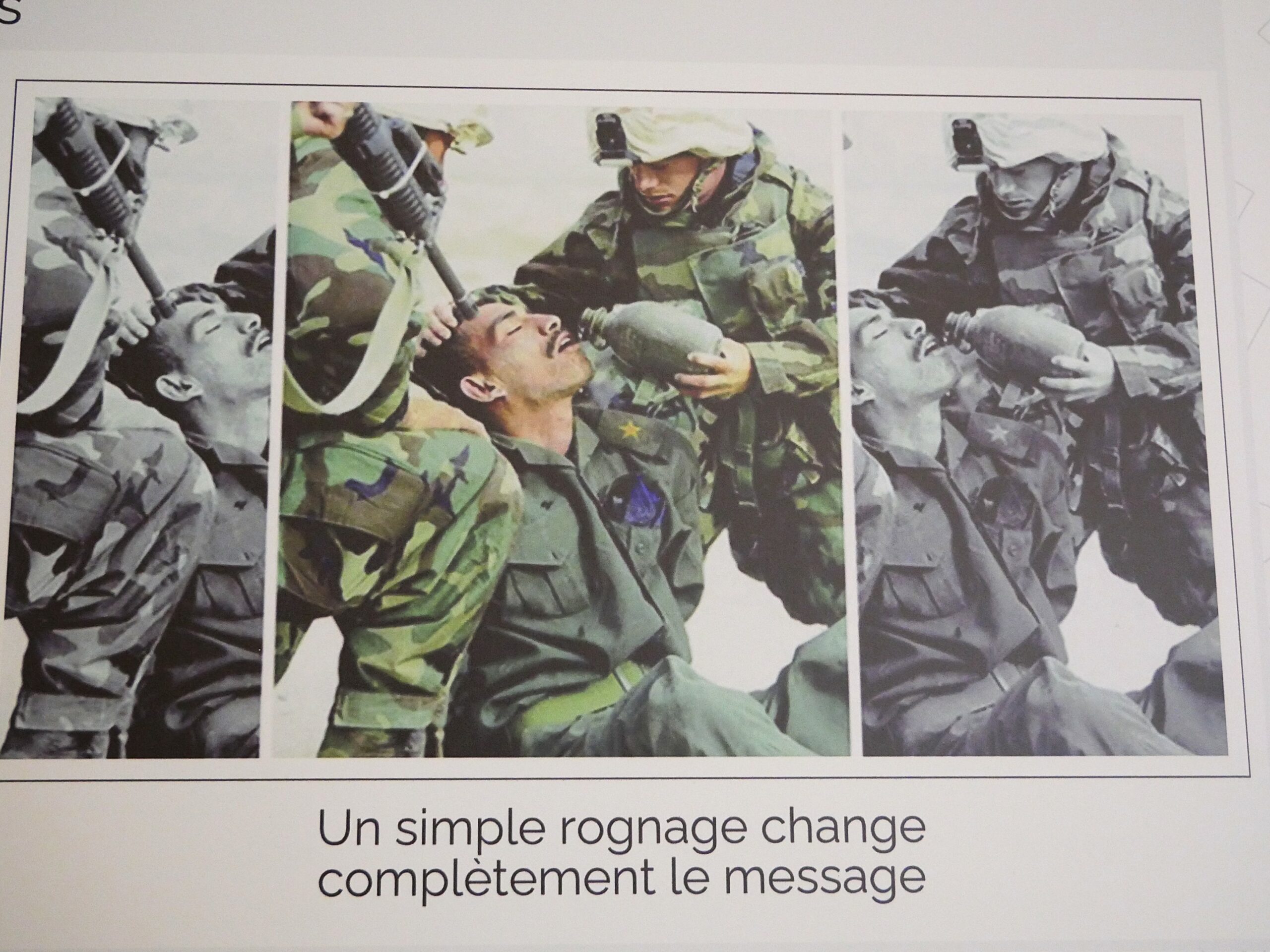

Autre technique bien connue, le rognage d’image qui change le sens et le message. « C’est du cheap fake, de la manipulation d’images réalisée avec des logiciels bon marché », ajoutent les spécialistes.

Les manipulations sont infinies selon les deux spécialistes : changer la teinte de l’image, coller des bouts d’images pour réaliser un visuel réputé officiel, changer l’échelle d’un graphique pour minimiser l’impact ou exacerber un phénomène, ralentir une vidéo, etc.

« La désinformation devient multimodale lorsque l’on ajoute du son et du texte alternatif à l’image », explique Benoit Yelle.

L’IA générative accentue la création de contenu trompeur de façon massive et abondante, en donnant accès à la création de clips vidéo de haute qualité. Qui n’a pas vu la vidéo de Gaza, devenue la Riviera du Moyen-Orient?

La voix n’échappe pas à ces manipulations. La reconnaissance vocale, aujourd’hui utilisée par les établissements bancaires à des fins de sécurité, peut être détournée et clonée par des fraudeurs grâce à des outils d’intelligence artificielle. « Beaucoup d’outils en open source sont disponibles facilement », se désole Benoit Yelle.

Ne pas suspendre son jugement!

« Il existe des algorithmes pour détecter des contenus trompeurs », rassure Marc Lalonde. Mais il conseille également d’utiliser son jugement ; des ombrages anormaux, des anachronismes, des irrégularités, une incohérence physique doivent alerter l’internaute. La fausse photo de Kate Middleton avec ses enfants a été débusquée par des internautes attentifs.

Les spécialistes recommandent également d’utiliser des outils de recherche d’images inversée comme la canadien TinEye, pour vérifier si une image a été publiée ailleurs.

« Les grands réseaux qui auraient les moyens de contrer cette désinformation se désengagent de la vérification, l’humain doit rester vigilant, il ne faut pas suspendre son jugement », croit Benoit Yelle.

Marc Lalonde cite les initiatives d’Adobe, de la BBC ou de Radio-Canada qui cherchent à protéger leurs images en assurant leur traçabilité dès le capteur de la caméra, pour être en mesure de les suivre.

Quel cadre juridique?

« Le système juridique est toujours à la remorque des avancées technologiques », déplore M. Yelle.

Des ajustements juridiques doivent être faits pour assurer une meilleure protection.

Benoit Yelle explique que le Code civil du Québec notamment protège contre les atteintes à la réputation, les atteintes à la vie privée, ou encore la responsabilité civile.

L’enjeu technologique reste de trouver la responsabilité du deepfake ; même si la loi ne comprend pas de dispositions spécifiques sur les hyperstrucages, le juge peut interpréter la loi.

Dans le Code criminel canadien, la loi prévoit des images captées mais pas des images modifiées par l’intelligence artificielle.

« Même si c’est un crime au Canada, comment poursuivre des manipulateurs d’images à l’étranger? C’est vraiment compliqué » conclut Benoit Yelle.

Pour en savoir plus : Désinformation visuelle et multimodale